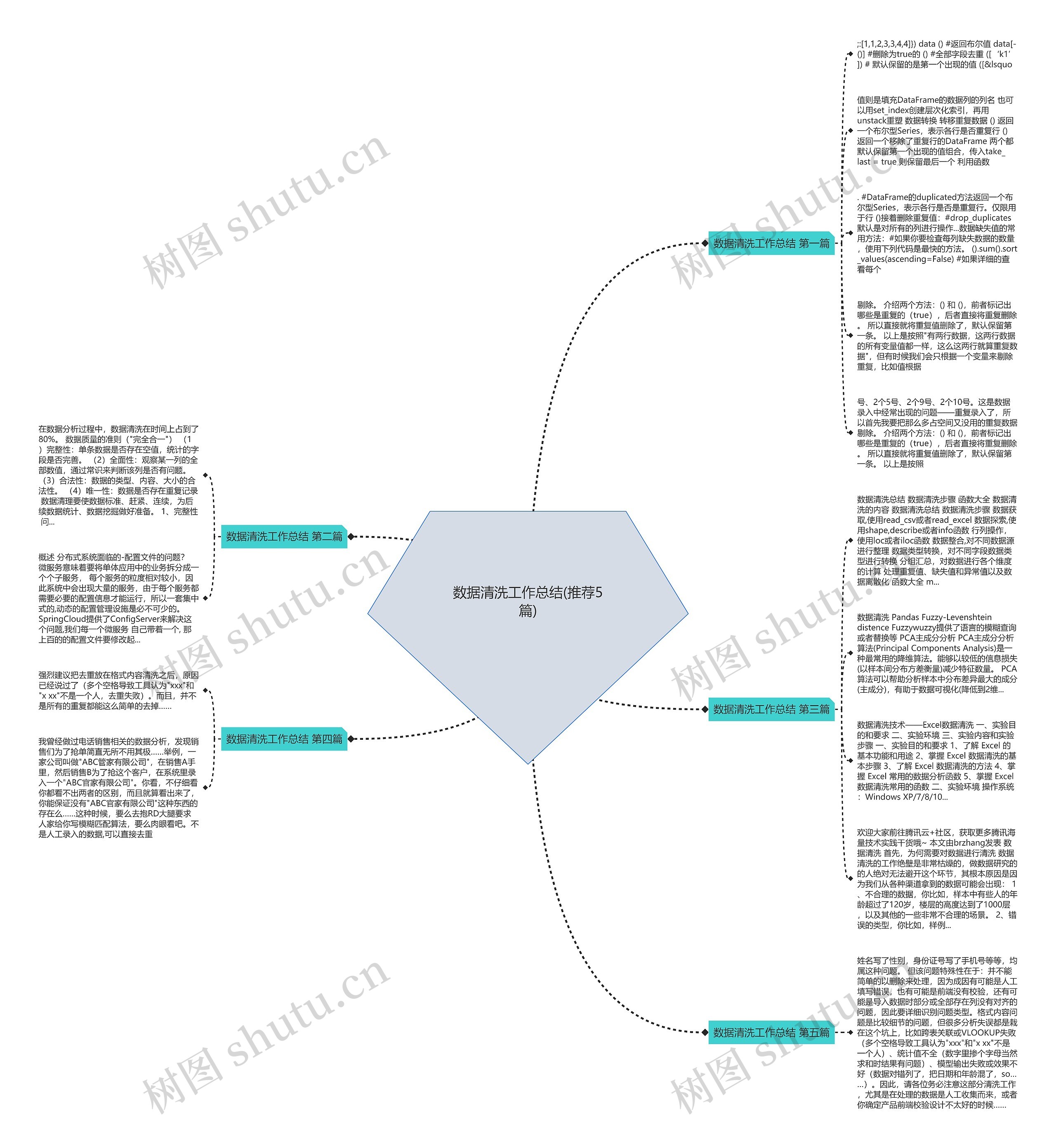

数据清洗工作总结(推荐5篇)思维导图

数据清洗工作总结 第一篇;:[1,1,2,3,3,4,4]}) data () #返回布尔值 data[-()] #删除为true的 () #全部字段去重 ([‘k1’]) # 默认保留的是第一个出现的值 ([&lsquo值则是填充DataFrame的数据列的列名 也可以用set_index创建层次化索引,再用...

树图思维导图提供 数据清洗工作总结(推荐5篇) 在线思维导图免费制作,点击“编辑”按钮,可对 数据清洗工作总结(推荐5篇) 进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:8bd76c3b2cf7b9bc4a23de6b7dbfa6b3

思维导图大纲

数据清洗工作总结(推荐5篇)思维导图模板大纲

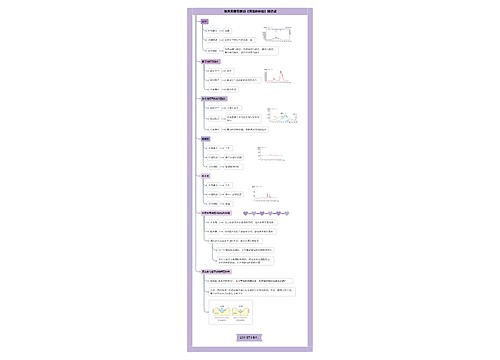

数据清洗工作总结 第一篇

;:[1,1,2,3,3,4,4]}) data () #返回布尔值 data[-()] #删除为true的 () #全部字段去重 ([‘k1’]) # 默认保留的是第一个出现的值 ([&lsquo

值则是填充DataFrame的数据列的列名 也可以用set_index创建层次化索引,再用unstack重塑 数据转换 转移重复数据 () 返回一个布尔型Series,表示各行是否重复行 () 返回一个移除了重复行的DataFrame 两个都默认保留第一个出现的值组合,传入take_last = true 则保留最后一个 利用函数

. #DataFrame的duplicated方法返回一个布尔型Series,表示各行是否是重复行。仅限用于行 ()接着删除重复值:#drop_duplicates默认是对所有的列进行操作...数据缺失值的常用方法:#如果你要检查每列缺失数据的数量,使用下列代码是最快的方法。 ().sum().sort_values(ascending=False) #如果详细的查看每个

剔除。 介绍两个方法:() 和 (),前者标记出哪些是重复的(true),后者直接将重复删除。 所以直接就将重复值删除了,默认保留第一条。 以上是按照"有两行数据,这两行数据的所有变量值都一样,这么这两行就算重复数据",但有时候我们会只根据一个变量来剔除重复,比如值根据

号、2个5号、2个9号、2个10号。这是数据录入中经常出现的问题——重复录入了,所以首先我要把那么多占空间又没用的重复数据剔除。 介绍两个方法:() 和 (),前者标记出哪些是重复的(true),后者直接将重复删除。 所以直接就将重复值删除了,默认保留第一条。 以上是按照

数据清洗工作总结 第二篇

在数据分析过程中,数据清洗在时间上占到了80%。 数据质量的准则("完全合一") (1)完整性:单条数据是否存在空值,统计的字段是否完善。 (2)全面性:观察某一列的全部数值,通过常识来判断该列是否有问题。 (3)合法性:数据的类型、内容、大小的合法性。 (4)唯一性:数据是否存在重复记录 数据清理要使数据标准、赶紧、连续,为后续数据统计、数据挖掘做好准备。 1、完整性 问...

概述 分布式系统面临的-配置文件的问题? 微服务意味着要将单体应用中的业务拆分成一个个子服务, 每个服务的粒度相对较小,因此系统中会出现大量的服务,由于每个服务都需要必要的配置信息才能运行,所以一套集中式的,动态的配置管理设施是必不可少的。 SpringCloud提供了ConfigServer来解决这个问题,我们每一个微服务 自己带着一个, 那上百的的配置文件要修改起...

数据清洗工作总结 第三篇

数据清洗总结 数据清洗步骤 函数大全 数据清洗的内容 数据清洗总结 数据清洗步骤 数据获取,使用read_csv或者read_excel 数据探索,使用shape,describe或者info函数 行列操作,使用loc或者iloc函数 数据整合,对不同数据源进行整理 数据类型转换,对不同字段数据类型进行转换 分组汇总,对数据进行各个维度的计算 处理重复值、缺失值和异常值以及数据离散化 函数大全 m...

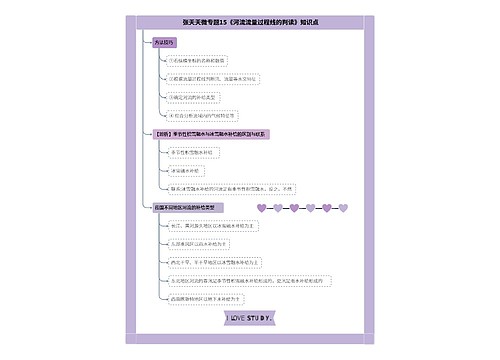

数据清洗 Pandas Fuzzy-Levenshtein distence Fuzzywuzzy提供了语言的模糊查询或者替换等 PCA主成分分析 PCA主成分分析算法(Principal Components Analysis)是一种最常用的降维算法。能够以较低的信息损失(以样本间分布方差衡量)减少特征数量。 PCA算法可以帮助分析样本中分布差异最大的成分(主成分),有助于数据可视化(降低到2维...

数据清洗技术——Excel数据清洗 一、实验目的和要求 二、实验环境 三、实验内容和实验步骤 一、实验目的和要求 1、了解 Excel 的基本功能和用途 2、掌握 Excel 数据清洗的基本步骤 3、了解 Excel 数据清洗的方法 4、掌握 Excel 常用的数据分析函数 5、掌握 Excel 数据清洗常用的函数 二、实验环境 操作系统:Windows XP/7/8/10...

欢迎大家前往腾讯云+社区,获取更多腾讯海量技术实践干货哦~ 本文由brzhang发表 数据清洗 首先,为何需要对数据进行清洗 数据清洗的工作绝壁是非常枯燥的,做数据研究的的人绝对无法避开这个环节,其根本原因是因为我们从各种渠道拿到的数据可能会出现: 1、不合理的数据,你比如,样本中有些人的年龄超过了120岁,楼层的高度达到了1000层,以及其他的一些非常不合理的场景。 2、错误的类型,你比如,样例...

数据清洗工作总结 第四篇

强烈建议把去重放在格式内容清洗之后,原因已经说过了(多个空格导致工具认为"xxx"和"x xx"不是一个人,去重失败)。而且,并不是所有的重复都能这么简单的去掉……

我曾经做过电话销售相关的数据分析,发现销售们为了抢单简直无所不用其极……举例,一家公司叫做"ABC管家有限公司",在销售A手里,然后销售B为了抢这个客户,在系统里录入一个"ABC官家有限公司"。你看,不仔细看你都看不出两者的区别,而且就算看出来了,你能保证没有"ABC官家有限公司"这种东西的存在么……这种时候,要么去抱RD大腿要求人家给你写模糊匹配算法,要么肉眼看吧。不是人工录入的数据,可以直接去重

数据清洗工作总结 第五篇

姓名写了性别,身份证号写了手机号等等,均属这种问题。 但该问题特殊性在于:并不能简单的以删除来处理,因为成因有可能是人工填写错误,也有可能是前端没有校验,还有可能是导入数据时部分或全部存在列没有对齐的问题,因此要详细识别问题类型。格式内容问题是比较细节的问题,但很多分析失误都是栽在这个坑上,比如跨表关联或VLOOKUP失败(多个空格导致工具认为"xxx"和"x xx"不是一个人)、统计值不全(数字里掺个字母当然求和时结果有问题)、模型输出失败或效果不好(数据对错列了,把日期和年龄混了,so……)。因此,请各位务必注意这部分清洗工作,尤其是在处理的数据是人工收集而来,或者你确定产品前端校验设计不太好的时候……

相关思维导图模板

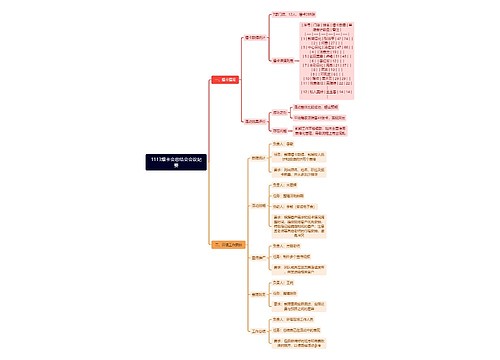

树图思维导图提供 1113爆卡会总结会会议纪要 在线思维导图免费制作,点击“编辑”按钮,可对 1113爆卡会总结会会议纪要 进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:aaf6c152a765d5821e8e1787f2b3226e

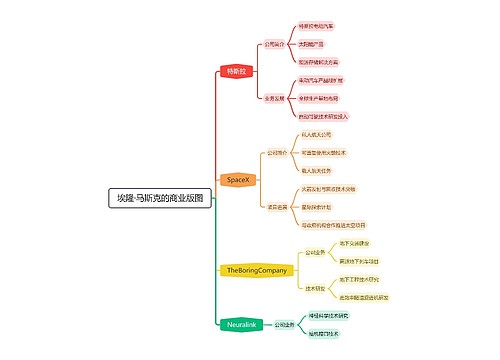

树图思维导图提供 埃隆·马斯克的商业版图 在线思维导图免费制作,点击“编辑”按钮,可对 埃隆·马斯克的商业版图 进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:7464362ac911e8a334867bb3fc7a2346

上海工商

上海工商